| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- 시각화

- 기계학습

- 서평

- 한국전자통신연구원 인턴

- cnn

- kt aivle school

- ML

- matplot

- 하계인턴

- ggplot2

- ETRI

- 에트리 인턴

- 에이블러

- Ai

- 에이블스쿨

- 지도학습

- 빅데이터분석기사

- SQL

- kaggle

- python

- 웹크롤링

- 빅분기

- SQLD

- 다변량분석

- arima

- KT AIVLE

- 한국전자통신연구원

- hadoop

- 가나다영

- KT 에이블스쿨

- r

- 시계열

- dx

- 프로그래머스

- 하둡

- 딥러닝

- httr

- Eda

- 머신러닝

- 소셜네트워크분석

Archives

- Today

- Total

소품집

[웹 크롤링] 웹 크롤링 프로세스의 이해 본문

728x90

우리가 인터넷에서 정보를 검색하는 방법

- HTTP란, 웹에서 데이터를 주고 받을 때 사용되며, 주로 HTML로 주고 받습니다.

- 데이터를 주고 받는 당사자는 '클라이언트'와 '웹서버' 입니다.

- 클라이언트가 웹서버 데이터를 요청하면 웹서버는 해당 요청에 대한 결과를 응답합니다.

웹 크롤링은 인터넷 검색과 유사하다

추가로 알아야 할 사항

- 크롬 개발자 도구

- 인코딩 및 로케일

- 다양한 에러 해결법

- 정규 표현식 (Regex)

HTTP 기초

- 인터넷 상에서 데이터를 주고 받을 때 사용

- 이때, 데이터를 주고 받는 당사자는 클라이언트와 웹서버

- 클라이언트 → 웹서버에 데이터를 요청, 웹서버 → 요청에 응답함

- 클라이언트(우리)가 요청할 때 사용하는 방식 중 많이 사용하게 되는 것은 GET(), POST() 방식

예시

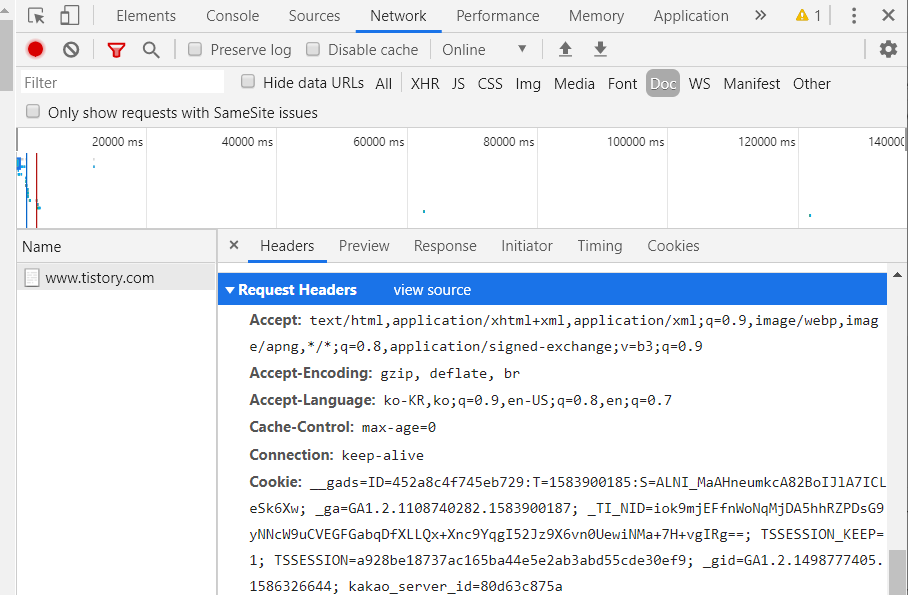

티스토리를 예시로 들면, Request Headers(요청헤더)에

- 가능한 콘텐츠 형식

- 가능한 인코딩 방식

- 쿠키

- User-agent

- Referer

등을 확인 할 수 있습니다.

GET 방식과 POST 방식에 대한 이해

GET 방식

-

웹 브라우저의 주소 창에서 보으는 URI만 가지고 웹서버에 요청하는 간단한 방식

-

페이지마다 별도의 URL이 있는 경우

-

'요청라인'과 '요청헤더' 를 보내야 함

POST 방식

-

페이지가 달라도 URL이 바뀌지 않음

-

크롬 개발자 도구에서 필요한 URL과 Parameters를 찾아야하는 다소 복잡한 방식

-

요청라인+요청헤더+메세지 바디를 추가

httr 패키지 사용법

URI vs URL

- URI는 Uniform Resource Indicator의 머리글자로, 리소스를 식별하는 문자열을 차례대로 배열한 것

- URL은 Uniform Resource Locator의 머리글자로, 리소스가 포함되어 있는 위치를 의미

httr 패키지 주요 함수 사용법

- httr은 HTTP요청 및 응답에 관한 작업에 사용되는 패키지 입니다.

2020/03/30 - [web crawling] - R로 네이버 실검 크롤링 하기

R로 네이버 실검 크롤링 하기

데이터 분석을 할 때 웹 크롤링을 해 웹 데이터를 수집 및 분석 하는 경우가 많은 데요. 그 중에서도 가장 기본인 내용으로 웹 크롤링을 연습 해보려고 합니다. 웹 서버는 html, css 등을 이용해 이미지 된 형상..

sodayeong.tistory.com

위에 글이 가장 기본적인 거로 뽑은,, 크롤링인데

20.04.09 현재는 선거로 네이버 실시간 검색어가 막혀있다.

728x90

'Web crawling' 카테고리의 다른 글

| [웹 크롤링] KOSPI 200 기업 (0) | 2020.04.25 |

|---|---|

| [웹 크롤링] JavaScript로 된 html 불러오기 (0) | 2020.04.13 |

| [웹 크롤링] 웹크롤링 쿠키 이용 (0) | 2020.04.09 |

| [웹 크롤링] 퍼센트 인코딩을 활용한 웹크롤링 실습 (0) | 2020.04.08 |

| [웹 크롤링] R로 네이버 실검 크롤링 하기 (0) | 2020.03.30 |

Comments